Nvidia DLSS 新模型显存减少20%,图像质量不减损

该优化仅适用于 DLSS 的图像超分模块,不包括帧生成(Frame Generation)部分。

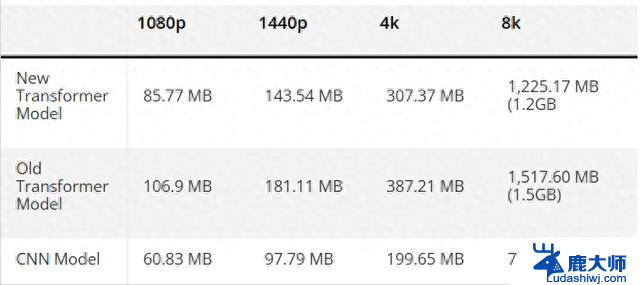

新模型显存更节省,接近旧 CNN 架构据 VideoCardz 首先发现的数据,在 1080p 分辨率下,旧版 Transformer 模型需占用约 106.9MB 显存;而最新版本仅需 85.77MB。相比之下,旧 CNN 模型约为 60.83MB。这意味着新版 Transformer 模型的显存开销仅高出 CNN 约 40%,而此前几乎是翻倍。

DLSS 显存开销会随着分辨率线性增长。例如在 4K 分辨率下,Transformer 模型将占用 307MB 左右 显存,而 8K 分辨率下甚至可超过 1GB。

实战影响有限,但技术进步明显尽管节省了 20% 显存,但对于现代显卡动辄 12GB 或 16GB 的显存容量而言,节省的几十 MB 显然难以感知。即便在 4K 下,也仅减少了约 80MB。除非在极限分辨率(如 8K)或显存紧张的特定场景中,才可能体现其实际优势。

不过从技术演进的角度看,这次优化仍具有重要意义。毕竟 DLSS 的 Transformer 模型参数量是 CNN 的两倍,能够提供更接近原生画质的超分效果。在此基础上还能降低资源占用,体现了 Nvidia 在 AI 图像处理领域的持续优化能力。

DLSS 4 帧生成也有单独优化

DLSS 4 帧生成也有单独优化需要注意的是,此次优化不涉及帧生成模块。不过 DLSS 4 在此前发布时也已对帧生成做出显存优化,最高节省幅度达到 30%。以游戏《战锤 40K:暗潮》为例,使用 DLSS 4 帧生成相比 DLSS 3 可减少约 400MB 显存使用。

Nvidia DLSS 新模型显存减少20%,图像质量不减损相关教程

- 微软迎接世界地球日:减少Win11设备对环境影响的绿色举措

- NVIDIA推出新版DLSS:Transformer模型转正,显存占用大幅降低

- OpenAI计划自研AI芯片,以减少对英伟达的依赖,将如何影响人工智能产业?

- 英伟达三季度营收翻倍,AI芯片热潮不减,新品开发无需许可证

- NVIDIA DLSS Transformer正式发布:8GB显卡显存占用降20%

- 微软开源的统一大模型评估框架:提升AI模型效率和性能

- NVIDIA终于修复了Linux上显卡游戏性能损失问题,性能提升高达20%

- AMD推迟发售锐龙9000系列处理器,不完全符合质量预期

- AMD Radeon RX 7600:尴尬显卡提频,显存容量翻倍,价格令人唏嘘!

- 英伟达30HX6G显存容量显卡3DMARK最高7000分,鲁大师28万1660,199元购买

- 微软不再允许关闭 Microsoft Store 中的应用更新,用户需及时更新应用程序

- 提高显卡散热效果的苏州元脑智能申请散热装置控制相关专利

- Win11卡顿?关掉这5个设置提速50%Win11卡顿解决方法

- 无需第3方工具,Windows10/11如何永久关闭自动更新?最简易方法揭秘

- Win10续命神器,5次点击延寿7年,让你的电脑焕发新生!

- 为什么网友觉得Windows XP和Windows 7是最经典的版本?这两个操作系统的特点让人无法忘怀

热门推荐

微软资讯推荐

- 1 微软不再允许关闭 Microsoft Store 中的应用更新,用户需及时更新应用程序

- 2 提高显卡散热效果的苏州元脑智能申请散热装置控制相关专利

- 3 无需第3方工具,Windows10/11如何永久关闭自动更新?最简易方法揭秘

- 4 为什么网友觉得Windows XP和Windows 7是最经典的版本?这两个操作系统的特点让人无法忘怀

- 5 **网购显卡防骗指南**

- 6 美国用户指控微软终止支持Win10逼迫用户升级设备

- 7 2025年8月最新CPU天梯图出炉!英特尔、AMD谁主沉浮?最新比较分析

- 8 微软Win11 Canary预览版27919发布:系统搜索设置整合优化

- 9 NVIDIA终于修复了Linux上显卡游戏性能损失问题,性能提升高达20%

- 10 微软发布 Windows 2030 战略:AI 与语音交互重塑 PC 未来,智能化助力未来PC发展

win10系统推荐

系统教程推荐

- 1 windows10flash插件 如何在Win10自带浏览器中开启Adobe Flash Player插件

- 2 台式机win10怎么调节屏幕亮度 Win10台式电脑如何调整屏幕亮度

- 3 笔记本电脑怎样设置密码开机密码 如何在电脑上设置开机密码

- 4 笔记本键盘不能输入任何东西 笔记本键盘无法输入字

- 5 苹果手机如何共享网络给电脑 苹果手机网络分享到台式机的教程

- 6 钉钉截图快捷键设置 电脑钉钉截图快捷键设置方法

- 7 激活windows7家庭普通版密钥 win7家庭版激活码序列号查询

- 8 wifi有网但是电脑连不上网 电脑连接WIFI无法浏览网页怎么解决

- 9 适配器电脑怎么连 蓝牙适配器连接电脑步骤

- 10 快捷删除是哪个键 删除快捷键ctrl加alt